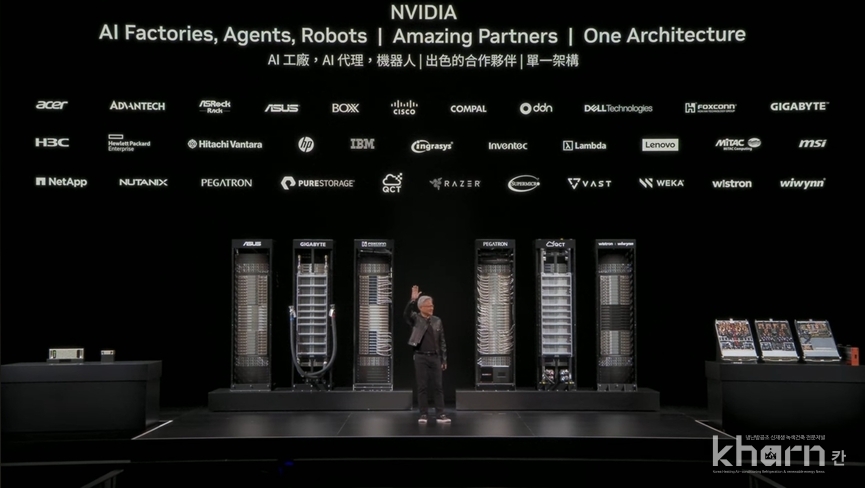

엔비디아(NVIDIA)가 그래픽 칩셋 제조사에서 시작해 서버플랫폼, 데이터센터(DC), 그리고 이제는 전 세계 산업의 기반이 되는 AI 인프라스트럭처 기업으로 진화하고 있다. 젠슨 황 CEO는 5월19일 컴퓨텍스(COMPUTEX) 2025 개막에 앞서 진행된 기조연설을 통해 이러한 전략적 전환을 종합적으로 선보이며 고성능 칩셋과 서버, 네트워크 인프라를 단일한 AI팩토리 개념으로 통합하고 있음을 강조했다. 컴퓨텍스 2025는 5월20일부터 23일까지 대만 타이페이에서 개최됐다.

특히 이 과정에서 쿨링기술은 더 이상 시스템 보조 기능이 아닌 전체 아키텍처 설계의 핵심으로 자리 잡았음을 드러냈다. 이번 기조연설에서는 직접적으로 ‘리퀴드쿨링이 표준’이라는 언급은 없었으나 고밀도·고전력시스템을 운용하기 위한 기술적 전제를 통해 이미 해당방식이 업계 표준이 됐음을 시사했다.

젠슨 황은 이번 발표에서 AI 산업을 전기(Electricity), 정보(Information)에 이은 세 번째 산업 인프라로 정의했다. 그는 전기시대의 단위가 와트(Watt), 정보 시대의 단위가 비트(Bit)였다면 이제 다가올 지능(Intelligence) 인프라시대의 단위는 '토큰(Token)'이 될 것이라고 강조했다. 생성형 AI가 인간의 언어, 이미지, 영상 등 다양한 표현 수단을 이해하고 만들어내는 능력을 갖추게 되면서 AI는 단순 연산도구가 아닌 창의적 결과물을 생산하는 엔진으로 진화하고 있다.

토큰은 AI모델이 입력된 데이터를 처리하고 결과를 생성하는 최소 단위를 의미한다. 자연어 처리에서는 문장을 쪼갠 단어 조각이나 서브워드, 숫자, 기호 등이 토큰이 된다. 예를 들어 ‘Artificial Intelligence’라는 문장이 입력되면 모델은 이를 ‘Artificial’과 ‘Intelligence’라는 두 개의 토큰 또는 그 이하 단위로 쪼개 처리한다. 생성형 AI는 이 토큰 단위를 기반으로 추론하며 다음 토큰을 예측해 결과를 만들어낸다. 이는 전통산업에서의 생산품 개념과 유사하다. 젠슨 황이 AI 팩토리를 ‘토큰 생산공장’으로 비유한 것도 이 때문이다.

AI 모델의 성능은 초당 생성할 수 있는 토큰 수(tokens per second)로 측정되며 이는 시스템의 처리량을 결정짓는 핵심 지표가 된다.

황 CEO는 “앞으로 기업들이 분기실적에서 얼마나 많은 토큰을 생성했는지를 보고할 것”이라며 AI 인프라시대에서 토큰이 새로운 경제단위로 작동할 가능성을 내비쳤다.

이러한 관점에서 엔비디아의 사업비전도 명확히 선포했다. 더 이상 칩셋이나 서버단위의 기업이 아니라 전 세계에 토큰생산이 가능한 인프라를 공급하고 관리하는 ‘산업인프라기업’이라는 것이다.

실제로 젠슨 황은 “우리는 기술회사가 아닌 인프라 기업”라며 “DC는 더 이상 정보 저장소가 아닌 AI 토큰을 생성하는 팩토리로 재정의된다”고 선언했다.

이러한 산업 전환은 GPU와 CPU를 넘어서 전체 전력설계, 냉각시스템, 네트워크 아키텍처, 소프트웨어 운영체제까지 아우르는 복합적 기술력을 필요로 한다.

엔비디아의 사업전략은 지난 수년간 뚜렷한 진화를 보여왔다. 초기에는 그래픽처리장치(GPU)라는 칩셋제조사로 출발했지만 이후 서버플랫폼 기업으로, 다시 대규모 DC 중심의 클라우드 인프라기업으로 진화했다. 그리고 이제는 AI 팩토리라는 이름 아래 AI를 중심으로 한 글로벌 인프라스트럭처 공급자라는 정체성을 선언하고 있다.

젠슨 황은 이번 키노트에서 이 같은 변화의 배경을 기술스택 전체의 재편성과 연결지었다. 엔비디아는 새로운 형태의 AI 인프라를 구축하기 위한 ‘AI 데이터플랫폼’을 중심으로 한 산업생태계 확장에 속도를 내고 있다. 이 플랫폼은 AI 추론 에이전트를 지원하며 방대한 문서와 비정형 데이터를 실시간으로 검색하고 분류할 수 있는 고성능 데이터인프라로 구성된다.

델 테크놀로지스, HPE, IBM, 넷앱, 퓨어스토리지, 바스트데이터 등 글로벌 스토리지 및 서버 선도기업들이 해당 플랫폼을 기반으로 인증제품을 출시하고 있으며 ODM 기업들 또한 GPU 통합, 섀시설계, 냉각기술을 포함한 맞춤형 서버·스토리지 솔루션을 개발하고 있다.

엔비디아 △RTX PRO 6000 Blackwell Server Edition GPU △BlueField DPU △Spectrum-X 이더넷 네트워킹 등도 해당 플랫폼과 연동되며 △RAG(검색증강생성) △NeMo Retriever △AI-Q 등 소프트웨어 모듈을 통해 에이전틱 AI 구현에 필수적인 요소들을 포괄한다.

그는 2006년 쿠다(CUDA)를 통해 GPU 병렬 연산 시대를 연 이후 2016년 DGX1 시스템을 시작으로 DC 수준의 연산집적을 실현했다. 이제는 Grace Blackwell(GB) 슈퍼칩을 통해 AI 팩토리라는 개념을 완성하며 칩 단위의 발전이 전체 산업인프라로 확장되는 일련의 흐름을 완결지었다.

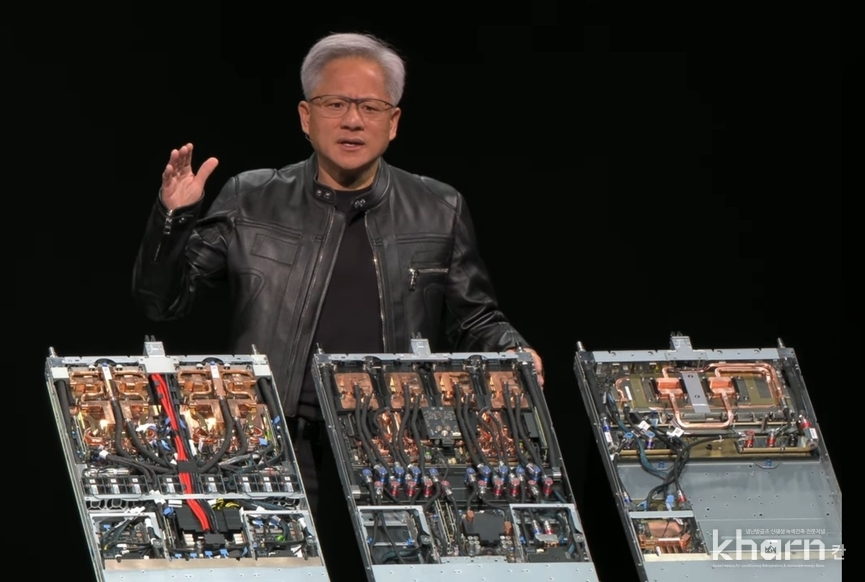

하지만 이러한 확장은 단순한 연산 능력의 향상만으로는 실현되지 않는다. 실제로는 전력공급, 네트워크 대역폭, 그리고 무엇보다 ‘발열관리’라는 물리적 한계의 돌파가 병행돼야 한다. GB시리즈는 최대 120kW 전력 소모를 수반하며 이는 기존 공랭식으로는 감당이 불가능한 수준이다.

젠슨 황 CEO는 키노트에서 직접적으로 리퀴드쿨링을 명시하진 않았지만 ‘100% 액체냉각’, ‘120kW 랙 전력밀도’ 등을 언급했다. 이러한 시스템설명을 통해 액체냉각 방식이 사실상 업계 표준으로 자리잡았음을 간접적으로 전제했다.

Grace Blackwell 기반의 시스템은 기존 슈퍼컴퓨터를 단일 랙으로 대체할 수 있으며 이를 가능케 한 NVLink Spine 구조는 5,000개 케이블과 130조개 트랜지스터로 구성돼 있다. 이러한 고밀도 아키텍처는 열 제거효율이 곧 시스템의 존속가능성을 결정짓는 요소다. 쿨링은 이제 시스템의 성능과 직결되는 인프라 핵심기술로 인식되고 있다.

엔비디아는 이와 같은 구조적 전환에 발맞춰 다양한 하드웨어 제품군을 대거 발표했다. DGX Spark는 개인연구자와 개발자를 위한 데스크탑 슈퍼컴퓨터로 1페타플롭스급 성능과 함께 고효율 냉각설계를 갖췄다. DGX Station은 벽면전원에서 운용 가능한 최대성능 모델로 대형 AI모델 학습까지 대응할 수 있다. RTX Pro는 엔터프라이즈 AI 서버로 기존 x86 환경과의 호환성을 유지하면서도 에이전틱 AI를 구동할 수 있는 최신 아키텍처를 반영했다. 이들 제품은 모두 고성능, 고밀도 설계를 기반으로 하며 이에 따라 냉각시스템은 필수 구성요소로 작동한다.

엔비디아는 쿨링을 포함한 전체 인프라를 지원하기 위해 다수의 파트너사와 협력하고 있다. △쿨러마스터 △AVC △Auras △델타 등은 Grace Blackwell의 고열을 직접 제어할 수 있는 커스텀 액체냉각솔루션을 제공하며 △폭스콘은 시스템조립과 PCB 생산에 참여한다. 이는 쿨링기술이 단순한 부품을 넘어서 랙단위 아키텍처 설계, 제조, 물류 등 전반에 걸쳐 통합돼야 함을 보여준다.

결과적으로 쿨링산업은 엔비디아의 전략변화에 따라 새로운 사업기회를 맞이하고 있다. 기존에는 서버 내부 팬, 히트싱크 수준에 머물렀던 쿨링기술이 이제는 DC 전체의 설계요건으로 격상됐다.

특히 액체냉각은 열교환기, 냉각수 순환시스템, 누수감지 및 모니터링시스템 등 복합기술로 구성되며 이 시장의 규모는 AI 팩토리 확산속도에 비례해 폭발적으로 확대될 것으로 예상된다.

젠슨 황은 키노트 말미에서 “우리는 AI를 위한 새로운 산업을 만들고 있다”라며 그 기반이 되는 물리적 인프라의 중요성을 재차 강조했다.

이는 AI시대는 알고리즘만으로 작동하지 않으며 전력과 냉각, 물리공간 등 근본적 요소 위에 세워지는 기술임을 의미하는 것으로 해석된다. 중심에는 쿨링이 핵심으로 자리잡고 있으며 쿨링은 더 이상 시스템 뒤편의 보조자가 아닌 AI산업을 움직이는 엔진이며 새로운 인프라의 전제 조건으로 부상하고 있다.